O cenário digital está a ser devastado por uma revolução silenciosa: os bots de Inteligência Artificial estão a devorar conteúdos a um ritmo alucinante… sem devolverem tráfego em troca. A relação simbiótica entre motores de busca e criadores de conteúdo está a ser destruída por modelos de IA famintos que sugam informação sem sequer gerar cliques.

Durante décadas, editores de conteúdo acolheram crawlers de motores de busca como o Googlebot. Porquê? Porque cada rastreio trazia potencial tráfego, essencial para monetizar através de visualizações e anúncios. No entanto, os bots de IA, como o GPTBot da OpenAI, vieram alterar as regras do jogo: consomem massivamente páginas HTML, reformatam a informação e apresentam-na diretamente aos utilizadores – sem que estes visitem a fonte original.

Dados da Cloudflare revelam um desequilíbrio assustador: o GPTBot faz 1.700 pedidos por cada referência ao site original. Já o ClaudeBot da Anthropic chega a números surreais, com 73.000 rastreios por cada clique gerado. O “crawl em troca de tráfego” morreu – e ninguém avisou os editores.

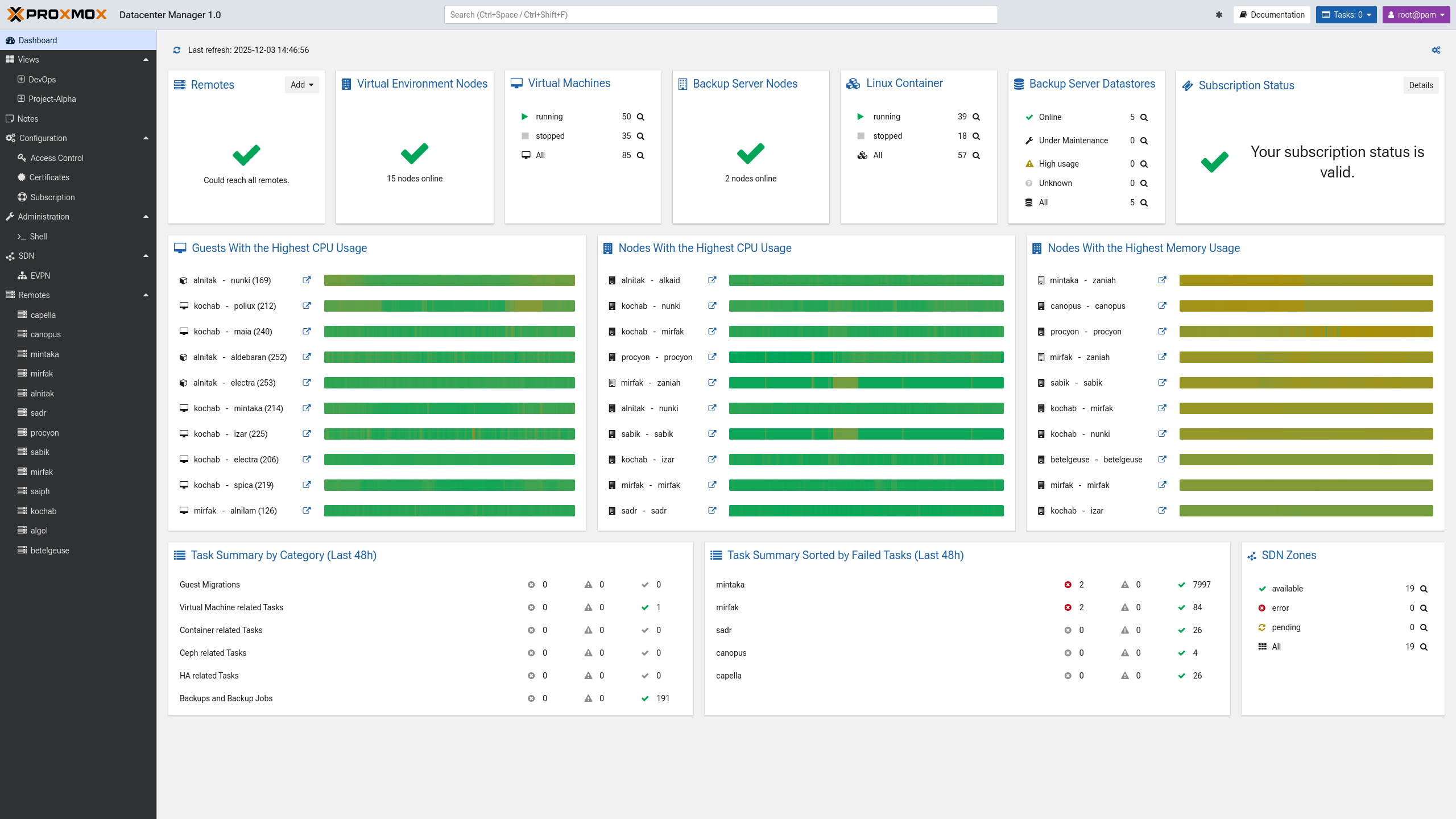

Esta nova geração de bots – entre eles ClaudeBot, Amazonbot, Meta-ExternalAgent e Bytespider – representa agora mais de 30% do tráfego de rastreio global, ultrapassando até o tráfego humano em certas regiões. O GPTBot lidera a investida, com um crescimento brutal de 305% em volume de pedidos num único ano. Por outro lado, o antigo rei Bytespider caiu a pique, com uma queda de 85%.

Os dados não mentem. Googlebot aumentou em 96% o seu rastreio entre maio de 2024 e maio de 2025. A integração de IA no motor de busca e o lançamento do AI Mode aceleraram esta tendência. Em paralelo, o novo GoogleOther também duplicou a sua atividade. A Google está a usar todos os recursos para dominar a indexação e treinar os seus modelos de IA – com ou sem consentimento dos sites.

Apesar de robots.txt ser uma ferramenta fundamental para os webmasters indicarem o que pode ou não ser rastreado, apenas 37% dos sites mais populares têm esse ficheiro ativo. E menos ainda configuraram corretamente as diretivas para bloquear bots de IA como GPTBot ou Google-Extended. A maioria continua vulnerável.

A Cloudflare lançou ferramentas gratuitas e poderosas para reequilibrar esta batalha digital: desde a gestão automatizada do robots.txt até ao bloqueio selectivo de bots de IA em páginas com anúncios. Isto permite aos criadores manterem a indexação para SEO, enquanto protegem o conteúdo rentável dos olhos indiscretos das IAs.

Nos bastidores, os bots disfarçam-se. Alguns fingem ser browsers legítimos. Outros mudam de IP constantemente. Mas a Cloudflare identifica-os através de padrões avançados de tráfego e deteção de fingerprints. Mais de 1 milhão de sites já ativaram o bloqueio de bots com um clique.

O gráfico de acesso revela um padrão preocupante: os crawlers aumentam, mas os referenciadores caem. Claude, OpenAI, Meta… todos rastreiam, mas quase não enviam visitantes. A tendência é clara: mais consumo, menos retorno. É um roubo de atenção digital autorizado por omissão.

Webmasters devem agir já. Auditar acessos, configurar robots.txt, e aplicar bloqueios dinâmicos é vital. Não se trata apenas de tráfego – está em jogo a sustentabilidade do ecossistema de conteúdos online. A IA não vai parar. Mas os criadores podem, e devem, impor limites.